Die Grundlage intelligenter, datengetriebener Entscheidungsfindung

Verständnis der Power BI-Architektur: ein umfassender Überblick

Reporting-Architektur: Das Fundament datengetriebener Entscheidungen

Die Reporting-Architektur ist das Framework, das Rohdaten in verwertbare Erkenntnisse umwandelt und Organisationen in die Lage versetzt, fundierte Entscheidungen zu treffen. Sie integriert Daten aus verschiedenen Quellen wie Datenbanken, APIs, Cloud-Plattformen und Datenstreaming-Tools wie Kafka. Diese Architektur stellt sicher, dass Daten reibungslos durch drei Kernstufen fließen: die Verbindung zu Datenquellen, die Analyse in Visualisierungsplattformen wie Power BI und Tableau sowie die Verbreitung der gewonnenen Erkenntnisse an Teams und Entscheidungsträger. Im Kern vereint die Reporting-Architektur robuste Integrationsprozesse (ETL/ELT), skalierbare Speichermöglichkeiten und intuitive Visualisierungstools. Dadurch können Organisationen sinnvolle Informationen extrahieren, analysieren und weitergeben. Power BI spielt dabei eine zentrale Rolle, indem es diese Elemente in einer einheitlichen Umgebung integriert und Berichte sowie Dashboards erstellt, die die Brücke zwischen Rohdaten und strategischen Erkenntnissen schlagen.

Power BI-Architektur verstehen: Ein umfassender Überblick

Einführung: On-Premises- und Cloud-Datenanalytik mit Power BI vereinen

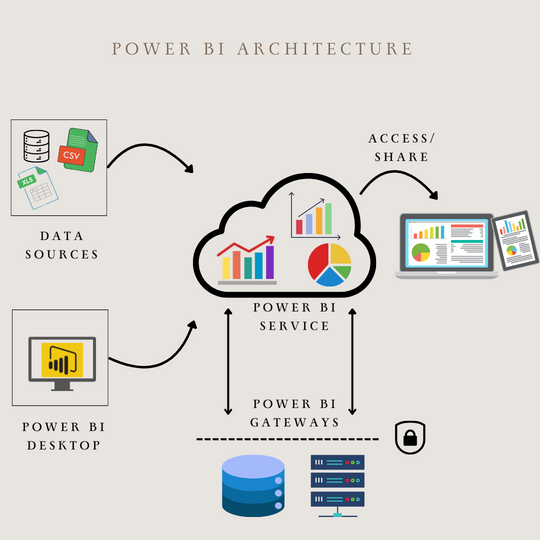

Power BI steht beispielhaft für moderne Reporting-Architektur, da es On-Premises- und Cloud-basierte Systeme nahtlos integriert und so unterschiedlichen organisatorischen Anforderungen gerecht wird. Mit seinen zwei Bereitstellungsoptionen – dem Power BI Report Server für On-Premises-Umgebungen und dem Power BI Service für Cloud-basierte Berichte – ermöglicht es Unternehmen, Sicherheit, Governance und Zugänglichkeit in Einklang zu bringen. Der Report Server, eine spezialisierte Version der SQL Server Reporting Services, erlaubt es Organisationen, Berichte lokal zu hosten und zu teilen, während eine strenge Datenkontrolle und Compliance gewährleistet werden. Der Power BI Service fungiert hingegen als Cloud-Rückgrat und bietet fortschrittliche Funktionen wie Echtzeitanalysen, kollaborative Dashboards und dynamische Visualisierungen. Seine Architektur kombiniert eine Weboberfläche für Benutzerverwaltung und Inhaltsverteilung mit einer Backend-Infrastruktur, die Azure SQL-Datenbanken, Blockspeicher und Echtzeitaktualisierungen nutzt. Sichere Verbindungen zu On-Premises-Daten werden über Power BI Gateways hergestellt, während Azure Service Bus den nahtlosen Datenfluss sicherstellt.

Power BI Desktop: Das Herzstück der Datenaufbereitung und Modellierung

Power BI Desktop bietet leistungsstarke Werkzeuge zur Datenbereinigung, -transformation und -modellierung, mit denen Benutzer visuell ansprechende Berichte erstellen können, die in den Power BI Service oder den Power BI Report Server veröffentlicht werden können. Die Vielseitigkeit zeigt sich in der Unterstützung verschiedenster Datenquellen, darunter dateibasierte Formate wie Excel und CSV, Datenbanken wie Snowflake und SQL Server sowie Power Platform-Tools wie Power Apps. Darüber hinaus integriert sich Power BI nahtlos mit Azure-Diensten wie Azure SQL-Datenbank und Blob-Speicher, Online-Plattformen wie Dynamics 365 und Salesforce, Web-APIs, Google Sheets und Spark und ermöglicht so eine umfassende Datenkonsolidierung für Erkenntnisse.

-

Import Data: Leistung und geplante Aktualisierung

Die Import Data-Methode lädt Daten in das In-Memory-Modell von Power BI, was eine schnelle Performance und erweiterte Funktionen wie Daten-Transformationen, DAX-Berechnungen und die Kombination mehrerer Datenquellen ermöglicht. Allerdings erfordert diese Methode scheduled refreshes, um Daten auf dem neuesten Stand zu halten. Diese Option eignet sich ideal für kleinere Datensätze oder Szenarien, in denen Geschwindigkeit und Flexibilität entscheidend sind, auch wenn bei größeren Datensätzen Größenbeschränkungen auftreten können, die mit Power BI Premium gelöst werden können.

-

DirectQuery: Echtzeitaktualisierungen mit Einschränkungen

DirectQuery verbindet sich direkt mit der Datenquelle und erfordert keine geplanten Aktualisierungen, da Berichte immer die aktuellsten Daten abfragen. Diese Methode unterstützt große Datenmengen, ist jedoch durch eingeschränkte Funktionen wie reduzierte Modellierungsoptionen und langsamere Visualisierungen aufgrund der Abhängigkeit von der Datenbank gekennzeichnet. DirectQuery eignet sich besonders für Echtzeitanalysen, bei denen die sofortige Aktualisierung wichtiger ist als Flexibilität.

-

Live Connection: Große Modelle und analytische Leistung

Live Connection verbindet Power BI mit Datenquellen wie Azure Analysis Services, SQL Server Analysis Services Tabular und Multi-Dimensional-Modellen sowie Power BI Service-Datasets. Ähnlich wie bei DirectQuery werden keine Daten im Speicher gespeichert. Stattdessen nutzt Live Connection die analytische Engine von SQL Server Analysis Services Tabular, wodurch große Modelle mit erweiterten analytischen Funktionen möglich sind. Live Connection ist ideal für Unternehmen, die Analysis Services für Skalierbarkeit und fortschrittliche Modellierung nutzen.

Power BI und Kafka: Echtzeit-Reporting ermöglichen

Power BI und Kafka ergänzen sich in modernen Datenarchitekturen: Kafka streamt Echtzeit-Ereignisdaten, während Power BI strukturierte Daten visualisiert und analysiert. Obwohl Power BI nicht direkt mit Kafka integriert ist, fungiert Azure Event Hubs als Kafka-kompatible Brücke, die Event-Streams für die nachgelagerte Verarbeitung verfügbar macht. Azure Stream Analytics transformiert und aggregiert diese Daten in strukturierte Formate, die Power BI verarbeiten kann. Diese Architektur kombiniert die Stärken von Kafka-Event-Streaming, Azure-Verarbeitung und Power BI-Dashboards, um Echtzeit-Erkenntnisse bereitzustellen.

Power BI und Enterprise Architecture Tools

Power BI integriert sich nahtlos in Enterprise Architecture-Tools wie Essential Cloud, ADoIT oder LeanIX und nutzt APIs, um Daten aus dem Enterprise-Meta-Modell zu visualisieren. Durch die Verwendung aktueller Daten wie Prozesse, Organisationseinheiten, Anwendungen, Schnittstellen, Technologiebausteine und Verantwortlichkeiten gewinnen Unternehmen tiefere Einblicke in ihre operative und technologische Landschaft. Diese Integration ermöglicht es, kritische Fragen zu beantworten, wie z. B. welche Legacy-Software noch im Einsatz ist, wer dafür verantwortlich ist oder wie schnell der technologische Wandel voranschreitet.

Kai Herings

Leitender Berater

Optimieren Sie die Abstimmung zwischen IT und Geschäft mit Expertenrat und klaren Strategien.